Home

Proyecto de Investigación en Inteligencia Artificial Aplicada

Universidad Tecnológica Nacional

Facultad Regional Haedo

Idioma

Esta página web está disponible en inglés ![]() y castellano

y castellano ![]() .

.

Descripción

La inteligencia artificial hace uso de las computadoras para aumentar las capacidades matemáticas y lógicas humanas. Este proyecto de investigación busca automatizar las habilidades humanas. Por otra parte, es necesario incentivar a los estudiantes de grado a una investigación temprana y a partir de los resultados obtenidos de sus investigaciones generar contenido educativo.

Objetivos de esta investigación

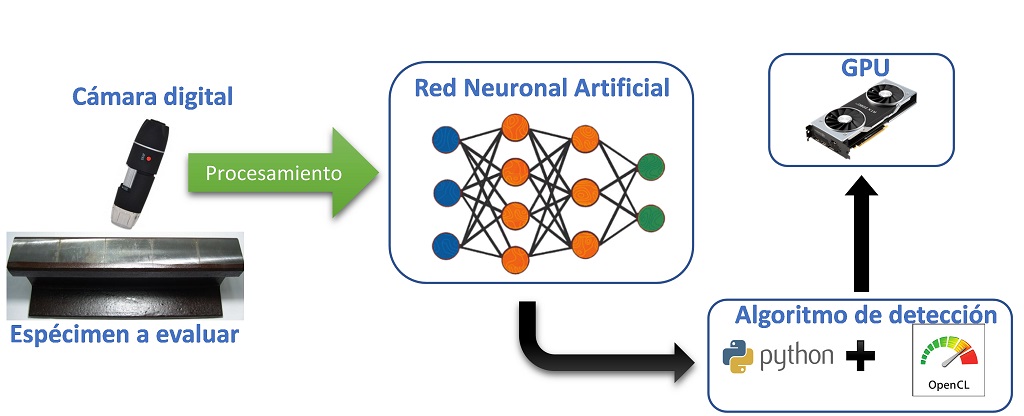

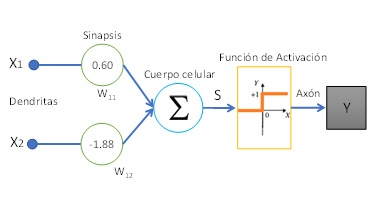

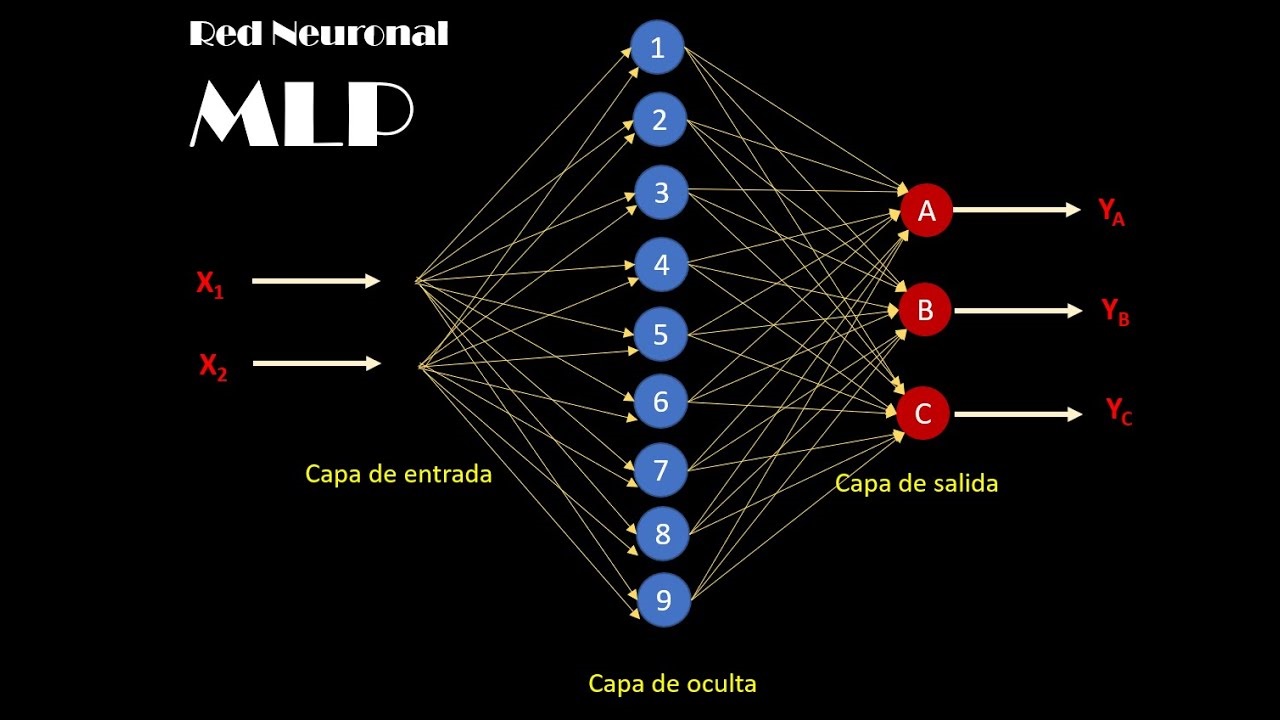

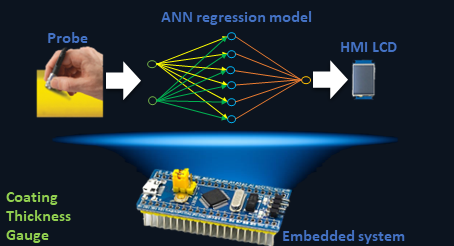

El ensayo no destructivo por visión artificial aplicado a materiales metálicos puede complementar a otras técnicas de inspección, para minimizar los errores de diagnóstico. Por otro lado, el aprendizaje profundo, por ejemplo, aplicado a la visión artificial, busca construir modelos matemáticos que aprendan de las imágenes que contienen fisuras u otro tipo de daño superficial. Los grandes volúmenes de datos que deben analizar las redes neuronales artificiales requieren de algoritmos específicos eficientes.